原廠連結

BTRFS 自我修復功能實測

儲存管理 - 硬碟讀寫效能測試

M2D17 M.2 SSD 轉接卡

DS3018xs + WD 4TB 硬碟*6 用電量預估

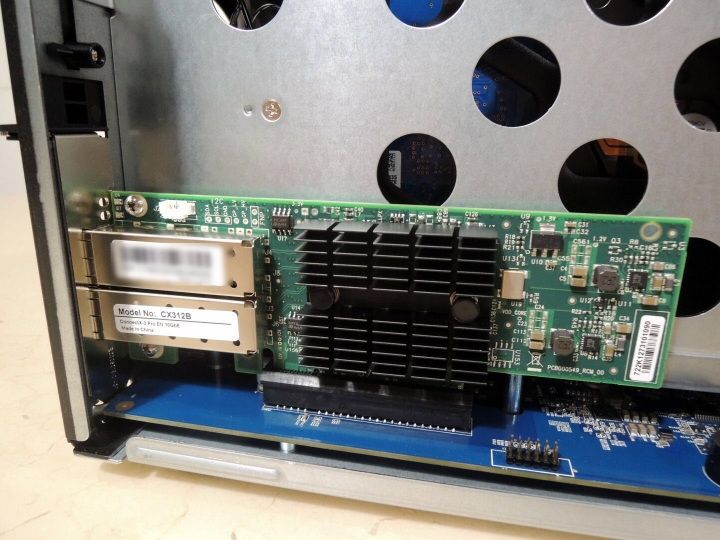

Mellanox ConnectX-3 10GbE 網卡實測 (CX-311A)

RAID 1/5/6 rebuild 效能實測

| 開箱 |

至於安裝設定這些步驟就直接跳過了, 這類的介紹及說明相當多, 大抵就是裝上硬碟後, 透過 browser 就可很快的完成初步設定, 另外在檔案系統的選擇上, DS3018xs 提供 btrfs & ext4 兩種檔案系統, 小弟建議就直接選用 btrfs 檔案系統, 支援快照及多項進階功能. 企業既然選擇 DS3018xs NAS, 我也想不出什麼理由不用 btrfs.

這台最大的問題就是M.2和10G只能2選1,所以我選擇加10G網卡犧牲1BAY裝SSD做讀取快取,其實這台的售價和定位應該是可以內建10G網路然後讓使用者可以自行添加M.2擴充卡要不然真的就是和918+一樣底部設計一個方便安裝的M.2擴充空間感覺才比較符合這台的定位。

這台最大的問題就是M.2和10G只能2選1,所以我選擇加10G網卡犧牲1BAY裝SSD做讀取快取,其實這台的售價和定位應該是可以內建10G網路然後讓使用者可以自行添加M.2擴充卡要不然真的就是和918+一樣底部設計一個方便安裝的M.2擴充空間感覺才比較符合這台的定位。